子豪 發(fā)自 凹非寺

量子位 報道 | 公眾號 QbitAI

先來看一張海島大片:

這可不是哪個攝影師的杰作,而是出自GANcraft之手。

原圖是「我的世界」中一個馬賽克畫質(zhì)的場景:

這下「我的世界」真的變成了,我的世界!

GANcraft由英偉達(dá)和康奈爾大學(xué)合作完成,它是一個無監(jiān)督3D神經(jīng)渲染框架,可以將大型3D塊狀世界生成為逼真圖像。

空前的真實(shí)感

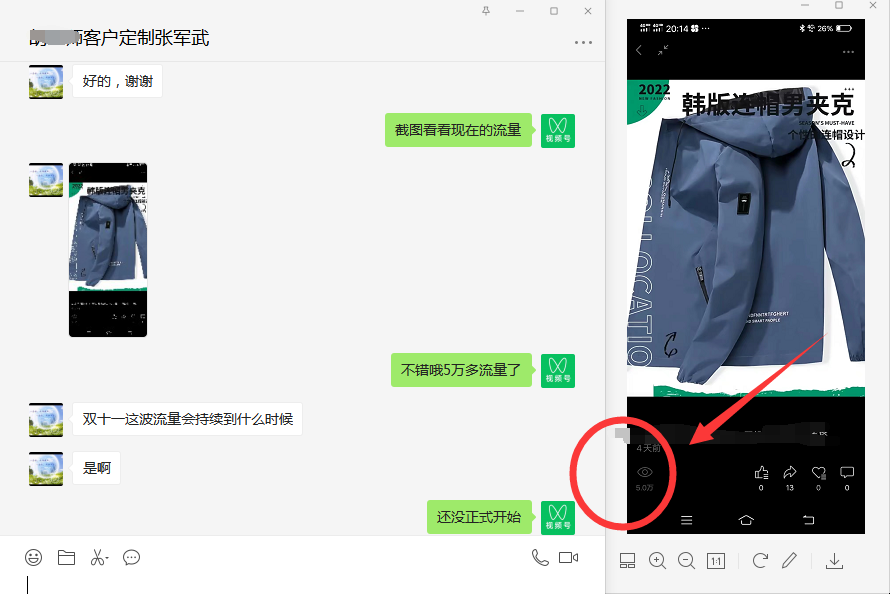

究竟有多逼真?和與其他模型對比來看。

以下是在兩個場景中,分別使用MUNIT、GauGAN用到的SPADE、wc-vid2vid,以及NSVF-W(NSVF+NeRF-W)生成的效果。

再感受下GANcraft的效果:(色彩和畫質(zhì)有所壓縮)

通過對比可以看到:

諸如MUNIT和SPADE這類im2im(圖像到圖像轉(zhuǎn)換)方法,無法保持視角的一致性,這是因為模型不了解3D幾何形狀,而且每個幀是獨(dú)立生成的。

wc-vid2vid產(chǎn)生了視圖一致的視頻,但是由于塊狀幾何圖形和訓(xùn)練測試域的誤差累積,圖像質(zhì)量隨著時間迅速下降。

NSVF-W也可以產(chǎn)生與視圖一致的輸出,但是看起來色彩暗淡,且缺少細(xì)節(jié)。

而GANcraft生成的圖像,既保持了視圖一致性,同時具有高質(zhì)量。

這是怎么做到的?

原理概述

GANcraft中神經(jīng)渲染的使用保證了視圖的一致性,而創(chuàng)新的模型架構(gòu)和訓(xùn)練方案實(shí)現(xiàn)了空前的真實(shí)感